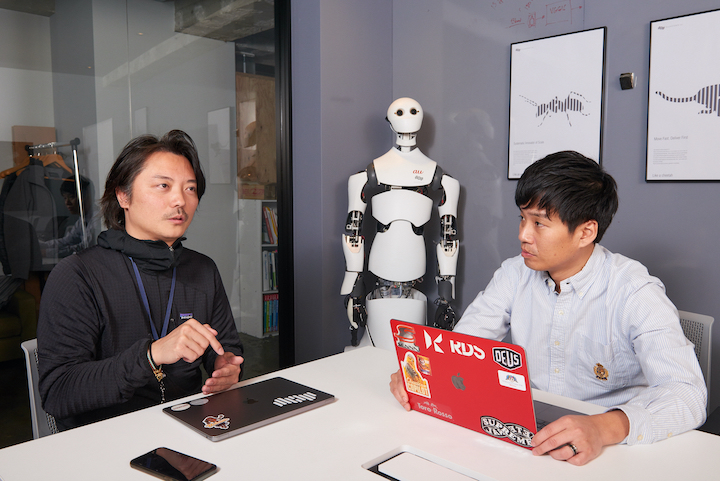

VRゴーグルや触覚センサー付きグローブを装着し、ロボットを自分の身体のように遠隔操作する。そんな未来がすでに現実のものとなっている。今回は、そんなロボティクスの世界をリードする、テレイグジスタンス社の共同創設者でありCEOの富岡 仁さんと、弊誌編集長・杉原行里の対談。同社は2020年9月14日から小売店舗の運営をスタートさせたというが、その真意とは?

テレイグジスタンスとは?

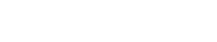

対談の前に、「テレイグジスタンス」について簡単に解説しておこう。「遠隔存在」「遠隔臨場」とも訳される「テレイグジスタンス」は、東京大学 名誉教授であり工学博士の舘 暲氏が1980年に提唱した概念。簡潔に言えば、人間がロボットの身体を操作し、自分の身体と同一のものとして行動できるようにする試みだ。館教授が考える最終ゴールはまだ先だが、約40年の研究成果により、かなりの進化と実現性を帯びてきている。そんななか、2017年に同研究の社会実装(商業化)を目的としたテレイグジスタンス社が設立された。富岡 仁さんは、その会社の共同創設者でありCEOである。

商社を辞め、

テレイグジスタンス社を

設立した理由

杉原 まずは、もともと三菱商事に勤めていた富岡さんが、一般的にはアバターと言われる、館先生の「テレイグジスタンス」の領域に興味を持った理由を教えてください。マーケティング的な側面なのか、何か思うところがあったのか。

富岡 それはよく聞かれるんですよ。でも、商社を辞めた時点では「テレイグジスタンス」をまったく知らなかった。商社は扱う金額が大きくて面白いんですけど、やっぱり線形でしか伸びないようなビジネスしか手掛けられない。大きなプロジェクトを2~3回やると、展開が読めてしまうというか。

杉原 パラダイムシフトが起きにくいということですね。

富岡 そうです。そこで、スタンフォード(大学経営大学院)を卒業し、ファンド組成と投資を経験した後、次に何をやろうかというときに、とりあえず複雑なことをしようと。技術的に複雑で難しいだけでなく、事業の仮説が4乗、5乗にも重なっていて、それを(事業としての)実態に変換する際には、複雑に利害が絡まった人たちを巻き込みながら、その煩雑さに糸を通していくような力量が要求されること。事業の経済計算も緻密さが要求され、モデル化が必要なこと。とにかく複雑系なことをやりたかったのです。

杉原 難攻不落かつ、ゼロイチ(世の中にないモノやサービス、価値を生み出すこと)のチャレンジングな仕事がしたかったんですね。

富岡 そうです。そして、いくつかの選択肢のなかで一番革新的で複雑そうなのが、館先生のロボティクスだった。難易度は異常に高いけれど、彼の技術をリサーチからエンジニアリングに引き上げ、ユニットエコノミクス(*1)を証明できれば、その後は事業が非線形で伸びるイメージが生まれました。

*1:SaaSやサブスクリプションサービスで扱われることの多い、ビジネスの最小単位1個あたりの収益性のこと

杉原 設立は2017年1月ですけど、当時はまだ遠隔操作はブルーオーシャンだったのでしょうか?

富岡 研究のひとつとしてはありましたけど、「ヒューマノイドロボット」を操作して云々というのはNASAの世界くらいでした。ですが、ロボットを遠隔操作する「マスター・スレイブ型」はごく一部の専門領域として昔からありました。

杉原 でも、「マスター・スレイブ(主人と奴隷)」ってすごい言葉ですよね。

富岡 あははは。ロボットの専門用語ですね。

2020年9月、遠隔操作ロボットが

コンビニの陳列を開始する

Model T

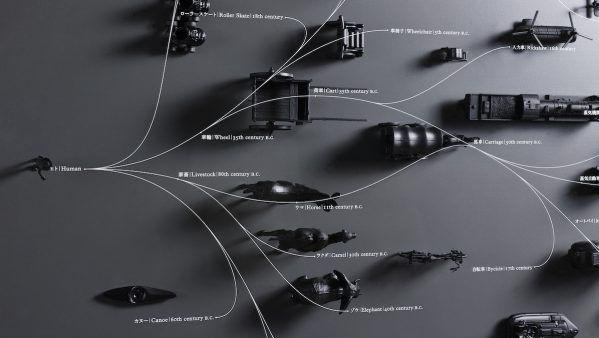

杉原 2018年に、テレイグジスタンスの技術、VR、通信、クラウド、触覚技術を盛り込んだ、プロトタイプの『Model H』という遠隔操作ロボットを開発されました。そしてついに、商業化に向けたサービスをローンチされるようですね。

富岡 そうなんです。まずは小売りの分野から始めていきます。今度、竹芝にソフトバンクの新本社ビルができるんですよ。AIやIoTを活用したスマートビルになっていて、その1Fに約50坪の、ロボットが導入されたローソンができる予定です。(*2)

*2 9月14日〜現在「ローソン Model T 東京ポートシティ竹芝店」にて導入

杉原 えっ! それはどういうことですか?

富岡 弊社が運営する店舗では、遠隔操作ロボットが多様な商品の陳列業務をするんです。

杉原 その遠隔操作ロボットは、どういうことができるのでしょうか?

富岡 『Model T』という遠隔操作ロボットで、移動しながらいろいろな商品を陳列していきます。従来の産業用ロボットアームは、工場内の極めて静的な環境下で、形状パターンが限定された物体をピック&ドロップすることがメインです。一方、工場の外で使おうとすると役に立たない。なぜなら、工場の外の世界は従来の産業用ロボットにとって環境設定がファジー過ぎるからです。小売りを例にすると、実店舗内でのライティング(照明)のパターンは無数にありますし、把持する商品が、食品と飲料だけでも約3500〜10,000種類以上あります。

杉原 それは画像認識がすごく大変になりますね。

富岡 まさに、すさまじいことになります。これを全て自律的におこなうには、まず画像認識で問題にぶつかります。商品の形状を認識し、さらに商品の傾きなどの姿勢推定、そして「ここを掴む」という把持点も認識しないといけない。現在のマシーンビジョン(*3)の技術レベルでは、実用レベルで解くにはかなり難しい問題設定になります。いわゆるフレーム問題というやつです。そんなとき、「テレイグジスタンス(遠隔存在)」が有効なアプローチになると思います。

*3:画像の取り込みと処理に基づいて機器を動作させるシステムのこと

杉原 インプットが膨大になりすぎて、時間もお金もかかりすぎることは人間がおこなうということですか?

富岡 人間ならば、あるモノを見たときにどう掴むべきかは5歳児でもわかる。それならば、人の目で掴むべき「把持点」を抽出したあとに、それを取ってA地点からB地点に持っていくのは従来のロボット工学の軌道計画でできる。そういう意味で人間が遠隔操作したほうが簡単だし安い。

杉原 遠隔操作する際、その『Model T』自体の距離感をディープラーニングしていくことも必要なのでしょうか?

富岡 現時点では、VRを使って人の目で合わせていきます。

個人がロボットを

所有して働かせる未来

杉原 こんなことを聞いていいのかわからないですが、『Model T』の時給はいくらになるのでしょうか?

富岡 そこがまさにビジネスモデルに関係していて、僕らは『Model T』を売らず、ロボットがおこなう役務提供(サービス提供)への対価を、雇い主からいただこうと考えています。わかりやすくいえば、人間が小売店舗で勤務するのと同等の価値と考えて、例えば陳列した分だけ対価を頂くという感じです。流行りの言葉で言えば「RaaS(robotics as a service)」ですね。 金額的には低賃金の小売業界でも、十分費用対効果が出るレベルにまで価格は抑えて導入可能です。

杉原 その計算でいけるとは、びっくりするくらい安いですね。これが5年前なら、ロボットの価格だけで3~4倍の値段になっていたはず。すごいイノベーションです。

富岡 TXはロボットのハードウェアを9割以上内製化して開発しています。また、ハードのみならず、ロボットの軌道計画、ロボット制御、遠隔制御、クラウド・通信、操作コクピットのUIなどもすべて内製化していて、高い柔軟性で製造コストをコントロールしています。ビジネスモデルの話に戻すと、東京の時給が約1200円。同じ仕事でも、賃金の低い県だと24時間365日勤務と考えた場合、年間200万円くらいの差がでるわけです。

杉原 そうですよね、遠隔操作であれば住んでいる場所は関係ない。しかも、いま話題の在宅勤務ができる。1時間だけスポットで入るとか、これまで通勤することができない事情を抱えた人でも働けるようになる。

富岡 まずは、小売り店舗の食べ物と飲料の陳列からスタートします。実は、それだけでも2200種類程度あるんですよ(笑)

杉原 そういう未来が来るとは思っていましたが、意外に早かったと感じます。ここから新しい職業が生まれ、さらにはこれまで仕事に就けなかった人たちの「選択肢」や「機会」が提示されることにもなる。ロボットが職場に進出することに関する、世間の誤解も解けそうな気がします。

富岡 そう思います。ロボットは今後、最も富を生み出す「資産」のひとつになりえる。でも、これまでのやり方のまま、『Model T』を大企業に売って彼らが使ってしまうと、ロボットから生み出される「富」が個人に「還元」されにくい。その意味でも、我々はロボットを「個人所有」させたい。個人が所有しているロボットが企業に役務提供することで、対価を得られる仕組みを構築したいんです。

杉原 企業からすると「投資」をする必要がない。また、労働者からすると自分がそこにいなくてもいい。さらには、ロボットをひとりで所有しなくてもいいわけですよね。

富岡 もちろん、何人かで所有していただいてもいいですし、それを使って誰が働くのかも問わない。

杉原 すごいビジネスが生まれそうですね。

富岡 5Gなどでインターネットのスピードが上がれば、日本で操作する必要すらないですよ。そうなると、時給差はもっと生まれると思います。逆に、海外の時給のいい仕事を日本でやることもできます。

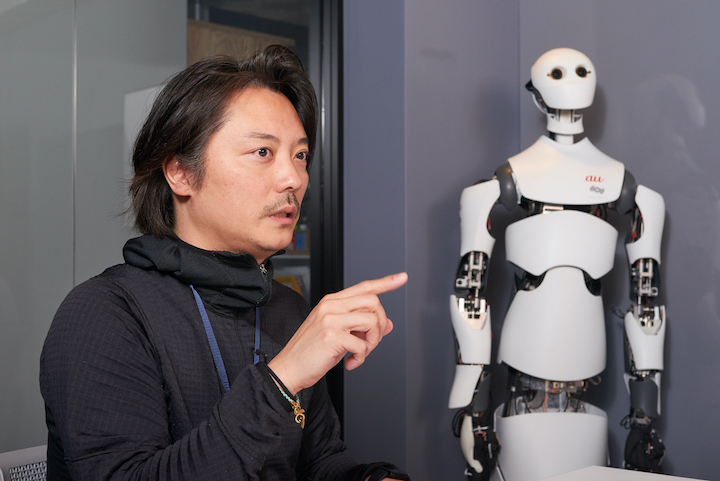

富岡 仁

テレイグジスタンス株式会社 代表取締役CEO、CFO兼共同出資者。

スタンフォード大学経営大学院修士。2004年に三菱商事入社し、海外電力資産の買収などに従事した。2016年にジョン・ルース元駐日大使らとシリコンバレーのグロースキャピタルファンド「Geodesic Capital」を組成し、SnapchatやUberなどへの投資を実行。東京大学の舘名誉教授のテレイグジスタンス技術に魅了され、2017年1月にテレイグジスタンス株式会社を起業。