外観から分かりにくい障がいの一つ、聴覚障害。国内で聴覚障がい者として認定を受けている人は約34万人と言われている。聴力レベルが低いという人まで入れると、その数は膨れ上がり約2000万人が耳の聞こえの悪さで苦労していると推定されている。聴力が少しでも残っていれば、補聴器や人工内耳といった手だても考えられるが、費用もかかり、また、環境により音が聞き取れないこともある。耳の不自由な人たちは、こうした不便さにいわば“妥協”して生きてきた。この「不便さの妥協」を食い止めるようなものが今、富士通株式会社で開発されている。

2020東京オリパラの公式スポンサーとなった富士通では、「3Dレーザーセンサー」による採点支援など、競技に直接的に関わる分野の開発をはじめ、2020東京オリパラに向けた様々な取り組みが始まっている。聾唖者をまじえた会議などで活用が見込まれるツールとして、販売がはじまった「LiveTalk」に手軽さを加え、健常者とも気軽にコミュニケーションが可能になるというのだ。このツールを使えば、手話を知らないボランティアも、会場への交通案内をスムーズに行うことが可能となる。多言語にも対応、障がいだけでなく、言語の壁をも飛び越える画期的なツールが誕生しようとしている。

きっかけは内部からの声

開発のきっかけについて語る大谷さん

「社内には聴覚障がいを持つ社員もいます。『FUJITSU Software LiveTalk』は、社内の会議などで、円滑なコミュニケーションがとりたいという彼らの願いから生まれました。普通の会話と仕事についての会話は性質や内容が異なります。一方的に話す方もいるので、そのような状況でもコミュニケーションをとりたいとの思いから、もともと研究されていた技術を富士通で開発販売するようになりました。今、隣にいる渡邉さんも社内会議でLiveTalkを使っています」(東京オリンピック・パラリンピック推進本部/プロモーション企画・推進統括部 統括部長大谷真美さん)

実際に使い方をレクチャーしてくれる東京オリンピック・パラリンピック推進本部/ビジネス企画・推進統括部の渡邉儀一さん(左)と株式会社富士通ソーシアルサイエンスラボラトリ 公共ビジネス本部 第三システム部 尾崎 純子さん(右)

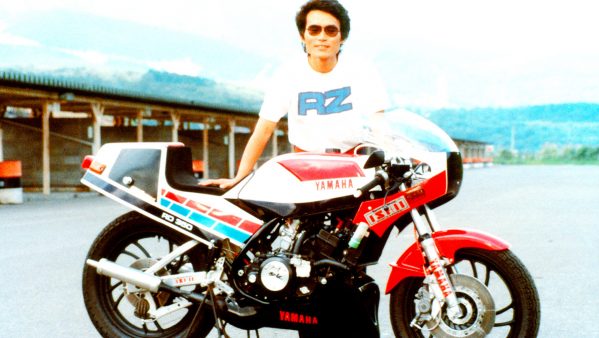

利用方法は簡単だ。ソフトウエアを購入し、パソコン端末に入れれば使えるようになる。マイクを通して発話された音声をクラウド上の音声認識エンジンが文字に変換、すばやくデータ化されてディスプレイされるという仕組みだ。話している途中でもどんどんテキスト化、しかも多言語化できるというのが富士通の技術だという。取材班も試させていただいたが、多少の誤変換はあるものの、確かに話すそばから文字化されていった。

「弊社のイベントで使った際は予め打ち込んだものが入っていると思われるほどでした。登壇者が言い間違えた時にはそれもそのまま表示されますので、その時になって、みなさん“えっ”と驚かれるくらい、そのくらいの速さで文字化されていきます」と話すのは、この開発に関わる 株式会社富士通ソーシアルサイエンスラボラトリ 公共ビジネス本部 第三システム部 尾崎 純子さん。キーボードを使った入力も可能で、コミュニケーションが取りやすいようにとスタンプも用意した。この「LiveTalk」は、富士ゼロックスサービスクリエイティブ株式会社ほか120社以上の会社や自治体ですでに利用がはじまっている。また、大学でも近年、導入する所が出てきている。

発話するとすぐさま文字化されたものがディスプレイされる

聴覚障がい者はキーボードを打つことで発言が可能に

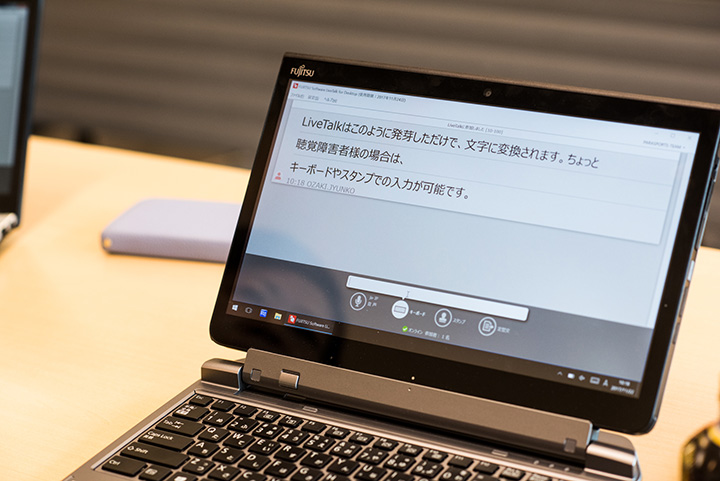

別アプリで画像やデータを表示し、その上に字幕のように発話内容を表示することも可能

聴覚障がい者が大学に入学した場合、授業の履修で手助けとなるのがノートテイカーというボランティア。だが、ここにも“課題”があった。ノートテイカーは、聴覚障がい者の隣に座り、ノートなどに先生の話すことを書いていく人のことで、聴覚障がい者はこのノートを頼りに授業に参加する。しかし、相手が読むことができる文字を人間が手書きで書くのは1分間に70文字程度。つまり、先生の発言をそのまま文字化していくことは難しく、内容が要約されてしまうこともあるのだ。

「『LiveTalk』の場合、先生の話が瞬時にそのまま文字化されるので、“授業に参加している”という意識を強く持てると好評です。サポートの人が書くとタイムラグが生じますが、『LiveTalk』はタイムラグはほぼありません。また、発話が要約されることもないので、聴覚障がい者の方からは『情報量が広がった』との声が聞かれました。先生の話すテンポや冗談など、今まで感じ取れきれなかった場の雰囲気的な部分も含めて受け取ることができるようになります」(大谷さん)

多言語翻訳にも挑戦

聴覚障がい者のために開発された「LiveTalk」だが、富士通では今後、多言語への翻訳ツールとしての展開を考えている。

聴覚障がい者のために開発された「LiveTalk」だが、富士通では今後、多言語への翻訳ツールとしての展開を考えている。

「多言語、英語や中国語など、最終的には19ヶ国語まで対応する予定です。2020東京オリパラなど、海外から沢山のお客様がいらっしゃった時に多言語でいろいろなことを表示できたり、とうぜん聴覚障がいをお持ちの方にもお使いいただけるように力を入れているところです。」(大谷さん)

これが可能となれば、世界中の人々から言語という壁が取り払われることになるだろう。また、会議の場やイベントだけではなく、病院の受付や病室での患者と看護師とのやりとりなど、さらに活用の場を広げられる様、開発に取り組んでいる。

手軽さをプラスしたイベント型「LiveTalk」を発表

この11月にリリースになったのが「LiveTalk」をさらに手軽に使えるようにしたものだ。「これまではクライアント端末にソフトをインストールしていただく形だったので、イベントなどで使用する場合は、サブスクリーンなどに発話内容や翻訳を投影していました。しかし、この方法だと座席や対応できる言語数に制約があります。そこで、登壇者が発話に使う『LiveTalk』のクライアント端末のみを用意すれば、イベントの期間中に利用申し込みをした来場者は、QRコードから発話内容や翻訳を確認できるというサービスをはじめました。」(尾崎さん)

「東京2020大会では、9万人のボランティア募集がかかると聞いています。そういう中で、会場では聴覚障がい者向けに手話通訳もあるとは思いますが、観光案内や会場へのルート案内など、会場以外の場面でもこうしたツールも活用すれば、より多くの人に東京2020大会を楽しんでいただけるようになると思っています」(大谷さん)

聴覚障がいの壁だけでなく、言語の壁をも飛び越えようとする富士通の技術。“不便の妥協”を突破する技術革新を2020東京オリパラを通して私たちは目にしようとしている。