目次

パフューム、サカナクションといった日本の人気アーティストや、ビョーク、OK Go、ノサッジ・シングといった世界的に有名なアーティストとのコラボレーションや、リオ2016大会閉会式、東京2020のフラッグハンドオーバーセレモニーでのAR映像演出などを手がけたライゾマティクスの真鍋大度氏。ライゾマティクス創業から15周年となる今春は、東京都現代美術館で大回顧展を開催したばかり。エンタテイメントからアート、スポーツ、医療と幅広いフィールドを横断しながら積極的に活動する真鍋氏を迎えた対談を前後編にてお届けする。

ライゾマティクスの飛躍は

ソフトとハードの両面にあり

杉原:僕が最初に真鍋さんを知るきっかけとなったのが、顔がピクピクする動画(electric stimulus to face /2008)だったのです。その時「ヒューマノイドの世界がついに来たんだ」と思いました。顔面の動きをトレースしていけば、今後は相当リアルなヒューマノイドが出来上がるんじゃないかと。

真鍋:今でこそSNSは当たり前ですが、当時はまだSNSもそこまで影響力がなかったですよね。やはりあの動画は海外で活動する大きなきっかけになりました。以前から同じようなことをやっていたのですが、なぜかあの動画だけかなりバズったんです。海外の人が見つけて面白がってくれたことが話題になった要因になっていたと思います。

杉原:それから、プリンターを使ったOK Goのミュージックビデオも印象的で、何度も繰り返して再生しました。あの動画は編集なしの一発勝負ということを聞いて、さらに驚いたんです。

真鍋:他にも似たようなことをやっている会社はあるのですが、ライゾマを評価していただいていることの1つの要因として、ハードウェアのエンジニアが多いことが挙げられると思います。なので、OK GoのMVのように大量のプリンターをハッキングして操作することができました。ソフトとハードの両方から難易度の高いことにアプローチできるので、「どうにもならなくなったらあいつらを呼ぼう」という感じで海外からオファーを受けることが多いんです。例えば広告の現場でドローンを上手く制御できなくて、どうにもならなくなって僕らが呼ばれるという。

杉原:はじめからライゾマにオファーするのは、ハードルが高いということでしょうか?

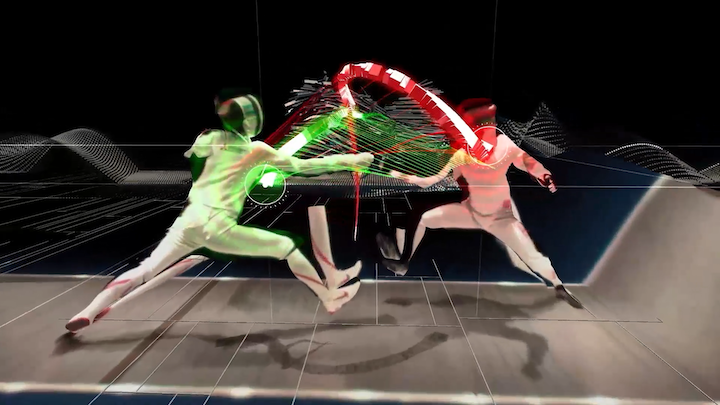

真鍋:というより、やはり最初はどの会社やチームも自分たちでやってみたいものなんですよね。難易度の高い仕事のひとつとしては、フェンシングの太田(雄貴)選手の剣先をマーキング無しで視覚化することがありました。

フェンシング・ヴィジュアライズド・プロジェクトついて

杉原:太田さんは前衛的な考え方で様々なテクノロジーやアイデアを柔軟に取り入れている印象ですよね。だから太田さんの一挙手一投足が注目されていたと思うし、ライゾマが剣先の動きを視覚化したことで、フェンシング競技の面白さが一気に高まりましたよね。本当に素晴らしいプロジェクトでした。

真鍋:ありがとうございます。2013年に、太田選手と電通からこれからのスポーツ観戦をテクノロジーの力でフェンシングをよりわかりやすく、魅力的に見せることが出来ないかというお題をいただき、ライゾマティクスが剣先を可視化するアイディアを提案、そしてプロトタイプの実装を担いプロジェクトがスタートしました。

杉原:剣道もそうだと思うんですが、フェンシングの勝負はあまりに一瞬すぎて、どう勝負が決まったのかが分かりにくいですからね。あれってカメラで剣先をトラッキングしたのですか? それとも加速度センサーを使ったのでしょうか?

真鍋:最初は剣先に再帰性反射材を付けてマーキングして、赤外線カメラを64台設置し剣先をトラッキングしました。モーションキャプチャの技術を使えば、トラッキングは可能でした。デモンストレーションとしてはそれで充分でしたが、本番の試合ではマーキングはできません。国際試合でもこの技術を使えるようにするためには機械学習技術を用いる必要があり、2013年時点では長い道のりになることは明確でした。ただ、東京オリンピックまでにはできるはずだと話をしました。

エイブル presents 第73回全日本フェンシング選手権大会

杉原:本当にゼロからのスタートな訳ですよね。剣先の動きをありとあらゆる変数でアルゴリズム作ってディープラーニングさせていくということですよね。ちょっと吐き気がするほどの作業量ですね(笑)。

真鍋:システム開発もそうですが学習データを作る作業が大変でしたね。僕は途中からディレクションに回り、開発はライゾマの花井というシニアエンジニア主導で進めたのですが、まずは練習試合の動画データを取得し、そこからアルバイトの手によって20万枚の画像に手動で人の骨格と剣先をラベリングしました。最終的なハードウェア構成もソフトウェアの処理も本当に複雑で、かつ映像的にもきちんと見栄えが良いものを作らねばならず「良くぞこれを実装しきったな……」とエンジニアたちが開発したのを横目で見て感動していました。

杉原:技術を実用化するためには、システムのスリム化が必要ですよね。でも、ゼロから始めるときは、どうしてもマッチョなシステムから始めるしかない訳ですね。我々のプロジェクトにも同じことが言えるので非常に共感します。ふと思ったんですが、イーロン・マスクが開発しているニューラリンク(脳とコンピュータをつなぐ技術)が進み、集積したデータを自分の脳に移植すれば、ものすごいフェンシングが上達するわけですよね。

真鍋:まだまだ先の話になるでしょうが、そうした未来もあるでしょうね。僕個人としては、その技術ができたら真っ先に埋め込んでみたい(笑)。

杉原:30年後の未来を考えていくと、拡張型の技術はもはや避けては通れないですからね。だから僕は“アート×テクノロジー”というところで、真鍋さんの作品から1歩先の提案書をもらっている感じなんです。

真鍋:そう言っていただけるのは本当にありがたいです。医療の分野は倫理の問題などがあり、出来ないことも多々あるので難しいですけれど。おっしゃる通り、アートはちょっと先の未来を実験するにはちょうどいい分野でもありますね。

2015年の取り組みをアップデートさせた

ELEVENPLAY × Rhizomatiks “border 2021”

杉原:リオ2016大会閉会式、東京2020のフラッグハンドオーバーセレモニーのAR演出なども本当に素晴らしかったですね。さて、僕は結局観に行けず非常に悔しんですが、今年2月に行われた“border 2021”のコンセプトやバックグラウンドを改めて教えてください。

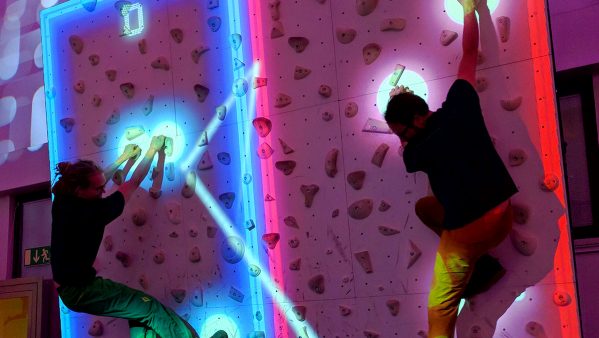

真鍋:ステージ上でパフォーマンスを体験しているお客さんもいるし、その様子を観客席の外から見ているお客さんもいる。そんな風にお客さんとパフォーマー、ステージと観客席、そういう境界線がない空間や入れ子構造になっている状態を作りたかったんですね。さらにリアルな現実とVRの世界をシームレスに行ったり来たりできるボーダレスな状態を作り出してみたいと思い、そこから“border”というプロジェクトが始まりました。たまたまパーソナルモビリティ・WHILL(ウィル:次世代型電動車椅子の名称であり、その開発会社)の人たちと仲良くなった時期ということもあり協力していただきました。最終的にはお客さんにMRゴーグルを装着してWHILLに乗ってもらった状態で、生のダンサーとVRのダンサーを体験する作品になりました。実際に開発して痛感したことなのですが、身体が車椅子で動かされることでさらに没入感が増すんです。

杉原:リアルと仮想のフュージョンみたいなところですね。没入感を高めるために身体の動きが重要だったというのは面白い発見ですね。

ELEVENPLAY x Rhizomatiks “border 2021” (2021) Photo by hiroko hirota(同、トップ画像)

真鍋:そのとき改めて分かったことは、大脳ではなく中脳に作用するということです。中脳は平衡感覚神経を司っている部位なで、普段やっているVRではそれほど意識しないのですが、WHILLによって身体を動かされることで、よりリアリティを感じやすくなるということが分かったのです。

杉原:僕もVRを利用した車いすレーサーCYBER WHEEL Xを作りました。自分の腕で漕いで、VR上で2100年の東京を走るという新感覚のゲームです。その時に仕掛けた技術は、加速度をきちんと理解してもらうためにトルクを入れたのです。それで一気に没入度が上がったんですよね。上り坂になると急に重くなる、下り坂やジャンプもリアルに感じる。ジェットコースターのようにお腹が浮く感じが苦手な人はちょっと酔ってしまう…(笑)。

真鍋:車酔いと一緒ですよね。これは当時FacebookにいたGoromanさんにアドバイスをいただいたのですが、自分の体は動いていないのに、例えばジェットコースターのようにVRの世界では視点がゴリゴリ動いているようなものは確実に酔ってしまうんですね。

実際に車椅子に乗って体験すること、身体を映像と合わせてきちんと動かすこと、それによって大脳だけでなく中脳がリアルと錯覚する。そこが没入感のポイントだったんです。脳科学者の方たちにも“border 2021”を体験していただきましたが、「本当にこれは初めての体験だ!」と感動してもらえたのが嬉しかったですね。

杉原:中脳が刺激されるとは驚きました。脳科学者の方々も非常に興味深いデータが取れたのでしょうね。アートを通じて、いろんな人たちとのネットワークに繋がったのですね。

真鍋大度(まなべ・だいと)

1976年、東京都生まれ。大学卒業後、大手電気メーカーに就職するが1年で退社。2002年 IAMAS(岐阜県立国際情報科学芸術アカデミー)に進学しプログラミングを学び、2006年Rhizomatiksを設立。以後、さまざまなアーティストのMVやライブ演出、スポーツイベントやファッションショーの演出を手がける。現在も東京を拠点に、アーティスト、インタラクションデザイナー、プログラマ、DJとして活動。

関連記事を読む

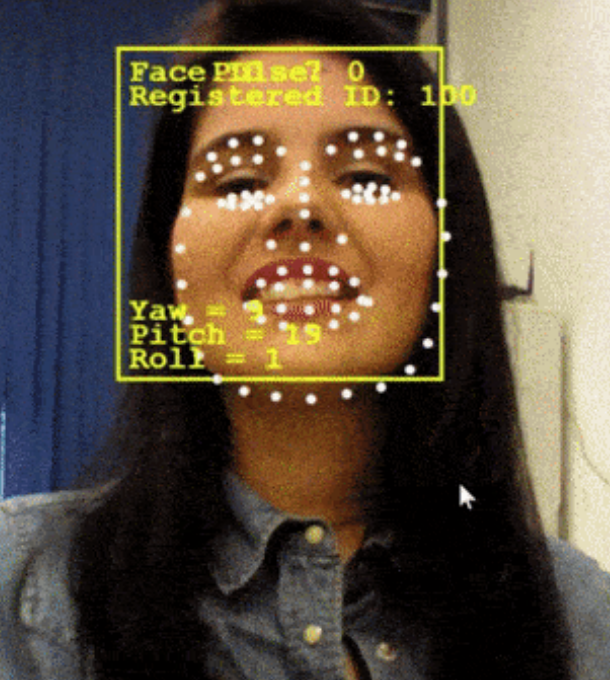

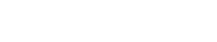

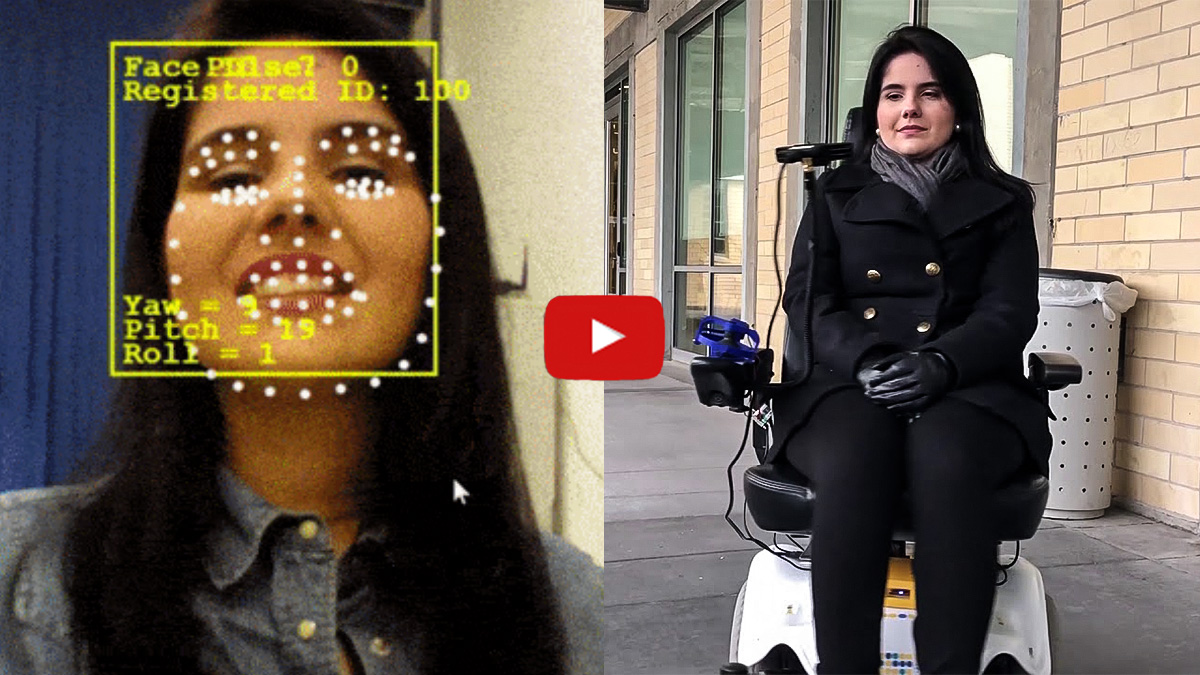

インテルが “The Wheelie” を生み出したブラジル、サンパウロのHOOBOX Roboticsと共同開発した “The Wheelie 7” では、3D IntelR® RealSense™ デプスカメラ SR300で捉えられた顔の表情が、リアルタイムのAIのアルゴリズムで処理され、いすを制御するデータをストリーミングする。

インテルが “The Wheelie” を生み出したブラジル、サンパウロのHOOBOX Roboticsと共同開発した “The Wheelie 7” では、3D IntelR® RealSense™ デプスカメラ SR300で捉えられた顔の表情が、リアルタイムのAIのアルゴリズムで処理され、いすを制御するデータをストリーミングする。